Las plataformas de IA conversacional están diseñadas para facilitar las interacciones naturales entre humanos y máquinas utilizando tecnologías como el procesamiento del lenguaje natural (NLP) y el aprendizaje automático (ML). Estas plataformas permiten que aplicaciones como chatbots y agentes virtuales participen en conversaciones significativas, lo que las convierte en herramientas valiosas en diversas industrias.

Resecurity ha observado un aumento en las campañas maliciosas dirigidas a agentes de IA y plataformas de IA conversacional que aprovechan los chatbots para proporcionar interacciones automatizadas y similares a las humanas para los consumidores.

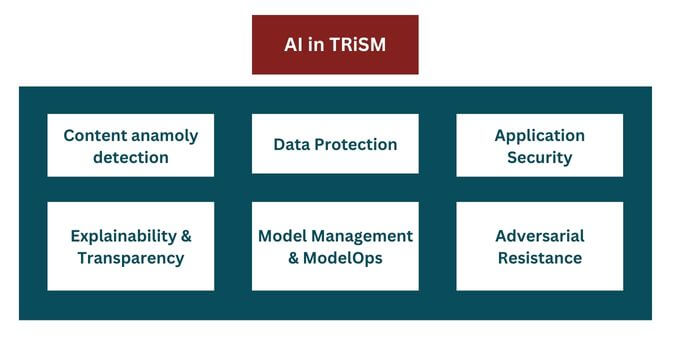

La IA generativa ha despertado un gran interés en los pilotos de inteligencia artificial, pero las organizaciones a menudo no consideran los riesgos hasta que los modelos o aplicaciones de IA ya están en producción o en uso. Un programa integral de gestión de confianza, riesgo y seguridad (TRiSM) de IA le ayuda a integrar la gobernanza tan necesaria desde el principio y a garantizar de forma proactiva que los sistemas de IA cumplan con las normas, sean justos, confiables y protejan la privacidad de los datos.

Los chatbots son una parte fundamental de las plataformas de IA conversacional, diseñados para simular conversaciones humanas y mejorar las experiencias de los usuarios. Las instituciones financieras (IF) están implementando ampliamente este tipo de tecnologías para acelerar la atención al cliente y los flujos de trabajo internos, lo que también puede desencadenar riesgos de cumplimiento y de la cadena de suministro.

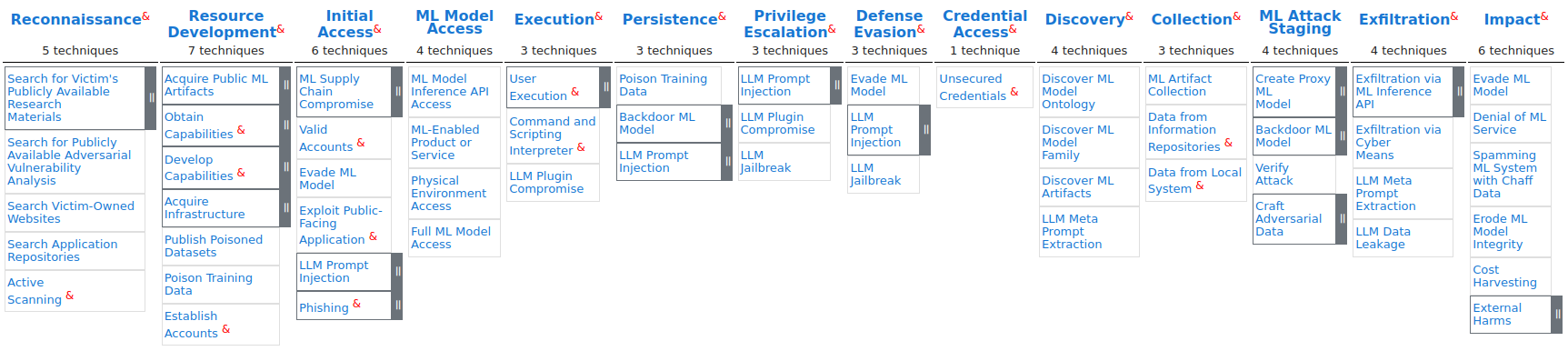

El espectro de tácticas y técnicas del adversario contra sistemas habilitados para Al basado en observaciones de ataques del mundo real se define en la Matriz MITRE ATLAS. Proporciona un marco para identificar y abordar vulnerabilidades en los sistemas de inteligencia artificial, lo que puede ayudar a prevenir ataques y proteger datos confidenciales, y permite a los investigadores navegar por el panorama de amenazas a los sistemas de inteligencia artificial.

Muchos de estos servicios no son totalmente transparentes en cuanto a la protección y retención de datos existentes, funcionan como una "caja negra" y los riesgos asociados no son visibles de inmediato. Eso puede explicar por qué las principales empresas de tecnología restringen el acceso de los empleados a herramientas de inteligencia artificial similares, particularmente aquellas proporcionadas por fuentes externas, debido a la preocupación de que estos servicios puedan aprovechar datos potencialmente propietarios que se les envían.

A diferencia de los chatbots tradicionales, los chatbots conversacionales de IA pueden ofrecer consejos y recomendaciones personalizados basados en las interacciones de los usuarios. Esta capacidad mejora la experiencia del usuario al proporcionar respuestas personalizadas que satisfacen las necesidades individuales. Los bots pueden recopilar datos valiosos de las interacciones de los usuarios, que pueden analizarse para obtener información sobre las preferencias y comportamientos de los clientes. Esta información puede informar estrategias comerciales y mejorar la oferta de servicios.

Al mismo tiempo, crea un riesgo importante en términos de protección de datos, ya que los datos recopilados de los usuarios pueden revelar información sensible debido a interacciones personalizadas. Otro aspecto importante es si los datos recopilados del usuario se conservarán para capacitación adicional y si dichos datos se anonimizarán posteriormente para minimizar la divulgación de PII (Información de Identificación Personal) y otros datos que puedan afectar la privacidad del usuario en caso de una infracción.

Una de las categorías clave de las plataformas de IA conversacional es el software de centro de llamadas y las suites de experiencia del cliente impulsadas por IA. Estas soluciones utilizan chatbots especialmente diseñados para interactuar con los consumidores procesando sus comentarios y generando información significativa. La implementación de soluciones impulsadas por IA como estas es especialmente significativa en fintech, comercio electrónico y gobierno electrónico, donde el número de consumidores finales es sustancial y el volumen de información a procesar hace que la interacción humana manual sea casi imposible o, al menos, al menos, comercial y prácticamente ineficaz.

Los modelos de IA capacitados optimizan la retroalimentación a los consumidores y ayudan con solicitudes adicionales, reduciendo los tiempos de respuesta y los procedimientos intensivos en humanos que la IA podría abordar.

En algún momento, las plataformas de IA conversacional comienzan a reemplazar los canales de comunicación tradicionales. En lugar de mensajes de correo electrónico de la "vieja escuela", estas plataformas permiten la interacción a través de agentes de inteligencia artificial que brindan respuestas rápidas y navegación multinivel a través de servicios de interés casi en tiempo real.

La evolución de la tecnología también ha llevado a ajustes en las tácticas de los adversarios que buscan explotar las últimas tendencias y dinámicas en el mercado global de las TIC para su propio beneficio. Resecurity detectó un notable interés tanto de la comunidad cibercriminal como de los actores estatales hacia las plataformas de IA conversacional debido a la gran cantidad de consumidores y los enormes volúmenes de información procesada durante las interacciones y sesiones personalizadas apoyadas por agentes de IA.

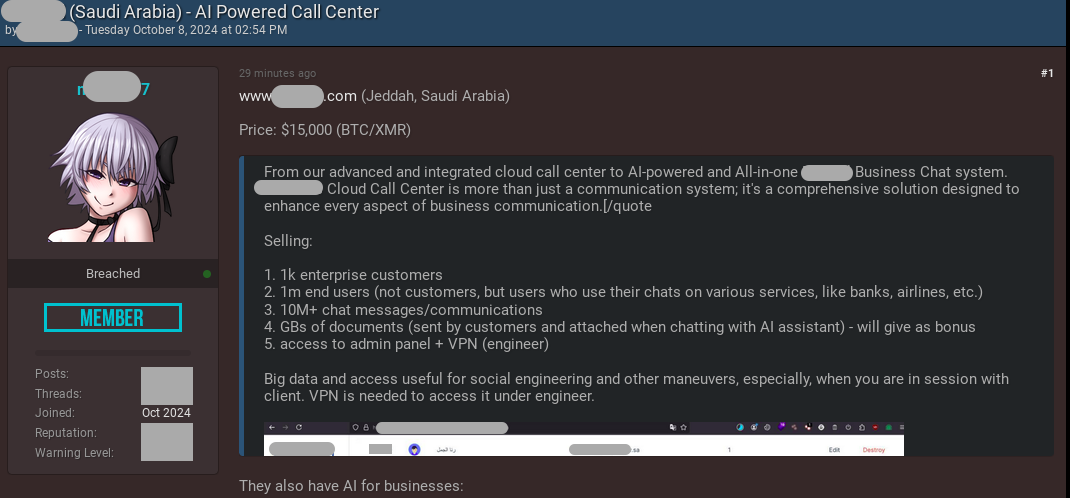

El 8 de octubre de 2024, Resecurity identificó una publicación en la Dark Web relacionada con la monetización de datos robados de una de las soluciones de centros de llamadas en la nube impulsadas por inteligencia artificial más grandes de Medio Oriente.

El actor de amenazas obtuvo acceso al panel de administración de la plataforma, que contiene más de 10.210.800 conversaciones entre consumidores y agentes de IA (bots). Los datos robados podrían utilizarse para orquestar actividades fraudulentas avanzadas, así como para fines cibercriminales utilizando IA.

Las filtración de agentes de IA y consumidores también revelaron información de identificación personal (PII), incluidos documentos de identificación nacionales y otros detalles confidenciales proporcionados para abordar solicitudes específicas. El adversario podría aplicar técnicas de extracción y minería de datos para adquirir registros de interés y utilizarlos en escenarios avanzados de phishing y otros fines ciberofensivos.

Como resultado del compromiso, los adversarios podrían acceder a sesiones específicas de clientes y robar datos y adquirir conocimiento sobre el contexto de interacción con el agente de IA, lo que luego podría conducir a un secuestro.

Este vector puede ser especialmente eficaz en campañas fraudulentas y de ingeniería social cuando el adversario se centra en adquirir información de pago de la víctima utilizando algún pretexto de verificación KYC o soporte técnico de una institución financiera o red de pago específica. Muchas plataformas conversacionales de IA permiten a los usuarios alternar entre un operador asistido por IA y un humano: el mal actor podría interceptar la sesión y controlar aún más el diálogo.

Al explotar la confianza de los usuarios, los malos actores podrían solicitar que las víctimas proporcionen información confidencial o organicen ciertas acciones (por ejemplo, confirmar una OTP) que podrían usarse en esquemas fraudulentos. Resecurity pronostica una variedad de esquemas de ingeniería social que podrían orquestarse abusando y obteniendo acceso a plataformas de IA conversacionales confiables.

La víctima final (consumidor) permanecerá completamente inconsciente si la sesión es interceptada por un adversario y continuará interactuando con el agente de IA, creyendo que la sesión es segura y que el curso de acción posterior es legítimo. El adversario puede explotar la confianza que la víctima tiene en la plataforma de IA para obtener información confidencial, que luego podría usarse para fraude de pagos y robo de identidad.

Además del problema de la PII retenida almacenada en las comunicaciones entre el agente de IA y los usuarios finales, los delincuentes también pudieron apuntar a tokens de acceso, que las empresas podrían utilizar para la implementación del servicio con API de servicios y aplicaciones externos.

Según Resecurity, debido a la importante penetración de sistemas externos de IA en la infraestructura empresarial y al procesamiento de volúmenes masivos de datos, su implementación sin una evaluación de riesgos adecuada debería considerarse un riesgo emergente de ciberseguridad de la cadena de suministro de TI.

AI Trust, Risk, and Security Management (AI TRiSM)

La implementación de la gestión de confianza, riesgos y seguridad de la IA (AI TRiSM) implica la creación y el mantenimiento de marcos que permitan que las tecnologías de IA se utilicen de manera responsable, ética y segura.

Los expertos describen la necesidad de una gestión de AI, así como de evaluaciones de impacto en la privacidad (PIA), para identificar y mitigar los impactos potenciales o conocidos que un sistema de IA puede tener en la privacidad, así como un mayor atención a la ciberseguridad de la cadena de suministro.

Componentes de AI TRiSM

- Gobernanza y cumplimiento: establecer estructuras de gobernanza claras que definan roles, responsabilidades y procesos para gestionar los riesgos relacionados con la IA. El cumplimiento de los requisitos legales y reglamentarios es fundamental y requiere que las organizaciones se mantengan al tanto de la evolución de las leyes y estándares de IA.

- Evaluación de riesgos: realizar evaluaciones de riesgos integrales para identificar posibles vulnerabilidades en los sistemas de IA, incluidos riesgos de privacidad de datos, preocupaciones éticas y amenazas a la seguridad. Esto implica evaluar las aplicaciones de IA en busca de sesgos algorítmicos, equidad y transparencia para mitigar posibles daños.

- Medidas de seguridad: implementar medidas de seguridad sólidas adaptadas a los sistemas de inteligencia artificial, como cifrado, control de acceso y auditorías de seguridad periódicas. Los mecanismos de detección de amenazas y las estrategias de respuesta son esenciales para protegerse contra las ciberamenazas y salvaguardar los datos confidenciales.

- Marcos éticos de IA: Desarrollar pautas y principios éticos para el uso de la IA que se alineen con los valores organizacionales y las normas sociales. Esto incluye la creación de protocolos para la toma de decisiones éticas y garantizar que las aplicaciones de IA respeten la privacidad y los derechos de los usuarios.

- Transparencia y explicabilidad: Luchar por la transparencia en las operaciones de IA, dejando claro cómo los sistemas de IA toman decisiones. La explicabilidad es crucial para generar confianza entre las partes interesadas, permitiendo a los usuarios comprender y cuestionar las decisiones impulsadas por la IA.

- Monitoreo y mejora continuos: Los sistemas de IA y su impacto deben monitorearse continuamente para identificar y abordar nuevos riesgos con prontitud. Las revisiones y actualizaciones periódicas de los marcos AI TRiSM garantizan que sigan siendo eficaces y relevantes a lo largo del tiempo.

- Participación de las partes interesadas: Interactuar con todas las partes interesadas, incluidos empleados, clientes y socios, para fomentar la comprensión de los principios de AI TRiSM. La formación y la educación son vitales para garantizar que las partes interesadas sean conscientes de los beneficios y riesgos de las tecnologías de IA.

- Colaboración y evaluación comparativa: colaborar con pares de la industria, organismos reguladores e instituciones académicas para compartir mejores prácticas y aprender de las experiencias de otros en AI TRiSM. La evaluación comparativa con los estándares de la industria puede ayudar a identificar áreas de mejora.

Las plataformas de IA conversacional ya se han convertido en un elemento crítico de la cadena de suministro de TI moderna para grandes empresas y agencias gubernamentales. Su protección requerirá un equilibrio entre las medidas tradicionales de ciberseguridad relevantes para SaaS (software como servicio) y aquellas especializadas y adaptadas a las particularidades de la IA.

Seis razones por las que necesita integrar AI TRiSM en modelos de IA

1. La mayoría de la gente no puede explicar qué es la IA y qué hace a los administradores, usuarios y consumidores de los modelos de IA.

Se debe explicar:

- los términos de la IA, para una audiencia específica;

- cómo funcionan los modelo;

- las fortalezas y debilidades del modelo;

- Su comportamiento probable;

- Cualquier posible sesgo;

2. Cualquiera puede acceder a ChatGPT y otras herramientas de IA generativa.

La GenAI puede potencialmente transformar la forma en que las empresas compiten y funcionan, pero también inyecta nuevos riesgos que no pueden abordarse con los controles convencionales.

En particular, los riesgos asociados con las aplicaciones de IA generativa alojadas y basadas en la nube son importantes y están evolucionando rápidamente.

3. Las herramientas de inteligencia artificial de terceros plantean riesgos para la confidencialidad de los datos.

A medida que la organización integra modelos y herramientas de IA de proveedores externos, también absorbe los grandes conjuntos de datos utilizados para entrenar esos modelos de IA.

Los usuarios podrían estar accediendo a datos confidenciales dentro de los modelos de IA de otros, lo que podría generar consecuencias regulatorias, comerciales y de reputación para su organización.

Para 2026, los modelos de IA de las organizaciones que ponen en práctica la transparencia, la confianza y la seguridad de la IA lograrán una mejora del 50% en términos de adopción, objetivos comerciales y aceptación de los usuarios.

4. Los modelos y aplicaciones de IA requieren un seguimiento constante.

Se deben integrar procesos especializados de gestión de riesgos en las operaciones del modelo de IA (ModelOps) para mantener la IA conforme, justa y ética.

No hay muchas herramientas disponibles en el mercado, por lo que probablemente se necesite desarrollar soluciones personalizadas para su canal de IA.

Los controles deben aplicarse continuamente, por ejemplo, durante el desarrollo, las pruebas y la implementación de modelos y aplicaciones, y durante las operaciones en curso.

5. Detectar y detener ataques adversarios a la IA requiere nuevos métodos.

Los ataques maliciosos contra la IA (tanto locales como integrados en modelos de terceros) provocan diversos tipos de daños y pérdidas organizacionales, por ejemplo, financieros, reputacionales o relacionados con la propiedad intelectual, información personal o datos de propiedad exclusiva.

Se deben agregar controles y prácticas especializados para probar, validar y mejorar la solidez de los flujos de trabajo de IA, más allá de los utilizados para otros tipos de aplicaciones.

6. Las regulaciones pronto definirán los controles de cumplimiento.

La Ley de IA de la UE y otros marcos regulatorios en América del Norte, China e India ya están estableciendo regulaciones para gestionar los riesgos de las aplicaciones de IA, y las empresas deben estar al tanto de estos desarrollos, añadió la empresa de ciberseguridad.

Por ejemplo, las recientes Directrices de IA del PDPC en Singapur ya alientan a las empresas a ser más transparentes al solicitar el consentimiento para el uso de datos personales mediante la divulgación y notificaciones. Las empresas deben garantizar que los sistemas de inteligencia artificial sean confiables, brindando así a los consumidores confianza sobre cómo se utilizan sus datos personales.

Referencias

- AI TRiSM: Tackling Trust, Risk and Security in AI Models | Gartner

- NIST Calls for Information to Support Safe, Secure and Trustworthy Development and Use of Artificial Intelligence | NIST

- Mitigate Emerging Risks and Security Threats from AI Agents

- AI TRiSM: What It Is & Why It’s Important

- Artificial Intelligence Trust, Risk and Security Management (AI TRiSM): Frameworks, applications, challenges and future research directions - ScienceDirect

- AI Trust, Risk and Security Management (AI TRiSM) Market

- AI Trust, Risk and Security Management (AI TRiSM) Market Size

- Ai Trism: AI trust, risk and security management in 2024, CIOSEA News, ETCIO SEA

- AI TRiSM Market: Navigating Trust, Risk, and Security in the Age of Artificial Intelligence

- AI Trust, Risk and Security Management Market Size

- AI Trust, Risk and Security Management (AI TRiSM) Market

- How Leading Consultancies Can Better Manage AI Risk

- The AI Tipping Point: Balancing Innovation, Security, and Trust

- Artificial Intelligence Risk & Governance - AI at Wharton

- Market Guide for AI Trust, Risk and Security Management

- Why AI TRISM (AI Trust, Risk and Security Management) Will Radically Change The Way We Live

- NIST releases new AI risk management framework for 'trustworthy' AI | VentureBeat

- SecurityAffairs

- Resecurity: Cybercriminals Are Targeting AI Agents and Conversational Platforms: Emerging Risks for Businesses and Consumers

- Tackling Trust, Risk and Security in AI Models

- Principles for responsible, trustworthy and privacy-protective generative AI technologies

- Engaging with Artificial Intelligence (AI)